🧑💻 요약

sLLM(Small LLM)은 LLM의 핵심 기능을 유지하면서도 연산 비용과 메모리 요구량을 크게 줄인 경량 모델로,

모바일·엔터프라이즈 환경에서 빠르게 확산되고 있습니다

. Phi-3, Gemma, Mistral, LLaMA 3 등 다양한 sLLM들이 클라우드·엣지 환경과 결합하면서

비용 절감부터 개인정보 보호, 빠른 응답속도까지 다양한 측면에서 실제 산업 활용 폭을 넓혀가고 있습니다.

안녕하세요. 카카오클라우드입니다. 요즘 AI에서 빠지지 않는 주제? 바로 LLM(Large Language Model)이죠. GPT나 Claude 같은 모델들이 세상을 변화시키고 있지만, 기업의 입장에서 이런 LLM 모델들을 운영하기엔 많은 컴퓨팅 자원이 필요하기에 부담스러운게 사실입니다. 그래서 등장한 게 바로 sLLM, 즉 '작지만 강한' 경량화된 대규모 언어모델입니다.🧐

sLLM은 LLM의 주요 기능을 유지하면서도 계산 자원, 메모리 요구량, 응답 시간 등을 획기적으로 줄인 모델로, 다양한 산업 분야에서 실용적이고 경제적인 AI 솔루션을 가능하게 하고 있습니다. 이 글에서는 sLLM이 뭔지, 기존 LLM과는 뭐가 다른지, 어떤 회사들이 잘 활용하고 있는지, 그리고 클라우드와 만나면 얼마나 강력해지는지에 대해 풀어보겠습니다.🙌

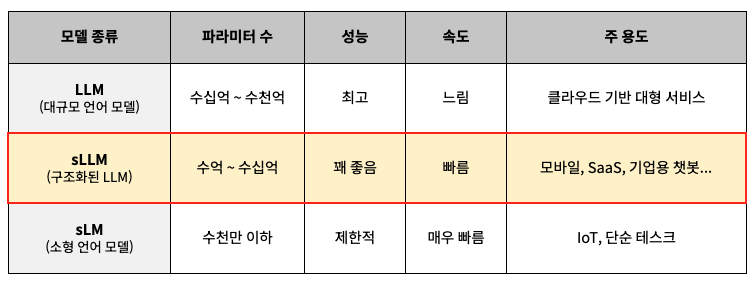

1. LLM, sLLM, sLM? 뭐가 다른 걸까요?

✅ LLM : GPT-4, PaLM 2, Claude.... 처럼 연산 능력과 자원이 충분한 환경에서 최고의 성능을 발휘!

✅ sLLM : LLM의 기능은 어느 정도 유지하면서 소형화! 일정 수준 이상의 언어이해 및 생성 능력을 유지해 기업용, 모바일용으로 적합.

✅ sLM : 경량형으로 특정 작업에만 특화되어 있는 모델. 일반적인 언어 생성에는 적합하지 않음.

2. 어떤 sLLM들이 있을까요?

☑️ Phi-3 (Microsoft)

- 1.3B에서 14B까지 다양한 크기의 sLLM을 제공.

- '3.8B 모델'은 모바일 디바이스에서도 구동이 가능할만큼 경량화되어있음. (성능: GPT-3.5 수준)

- 활용 예 : Windows Copilot, Microsoft 365에 들어간 온디바이스 AI

☑️ Gemma (Google)

- Google DeepMind에서 개발한 오픈 소스 모델로 2B 및 7B 파라미터 모델을 제공.

- 연구 및 상업적 활용이 모두 가능한 라이선스를 제공해 기업들이 빠르게 PoC 진행 가능

- 활용 예 : Google Cloud Platform에서 로컬 배포 및 API 연동을 통해 SaaS 제품에 통합

☑️ Mistral (Mistral.ai)

- Mistral 7B, Mixtral 12x8B와 같은 경량화와 고성능을 동시에 추구하는 모델 제공.

- LoRA(저차원 어댑터)와 같은 경량 파인튜닝 기법과의 호환성 뛰어남.

☑️ LLaMA 3 (Meta)

- Meta의 LLaMA 3 시리즈 중 8B 모델이 sLLM으로 분류됨.

- 자연서 생성, 질의 응답, 요약 등의 다양한 작업에서 높은 성능을 발휘.

- 활용 예 : WhatsApp, Instagram (Meta 플랫폼 내부의 챗봇 서비스에 적용중)

3. 클라우드랑 만나면 더 강력해지는 sLLM

sLLM은 클라우드 컴퓨팅 서비스(CSP)와 결합함으로써 그 활용도가 더욱 확장되고 있습니다. 이는 클라우드 플랫폼 서비스가 sLLM의 배포, 확장, 유지보수를 용이하게 만들며, 다양한 기술적 시너지를 제공하기 때문입니다. 예를 들어, AWS SageMaker, Google Vertex AI, Microsoft Azure Machine Learning Studio와 같은 서비스는 sLLM을 컨테이너 기반 또는 API 형태로 유연하게 배포할 수 있도록 지원하여 빠른 실험과 확장 가능한 서비스 운영을 가능하게 합니다. 또한 클라우드의 Auto-Scaling 기능을 통해 GPU 리소스를 온디맨드 방식으로 조절할 수 있어, 피크 시간대에도 성능 저하 없이 안정적인 서비스 제공이 가능합니다. 여기에 더해, 중요한 데이터는 엣지(Edge) 환경에서 처리하고 고난도 추론은 클라우드에서 수행하는 하이브리드 아키텍처를 구현함으로써, 기업은 개인정보 보호와 고성능 추론이라는 두 가지 요구를 동시에 만족시킬 수 있습니다. 마지막으로, 클라우드 기반의 MLOps 환경은 sLLM의 버전 관리, 재학습, 성능 모니터링 등을 자동화하여 운영 효율성을 높이고, 지속적인 성능 개선과 안정적인 서비스 운영을 지원합니다.

4. sLLM이 산업에 주는 변화

요즘 산업 전반에서 sLLM(Structured LLM)이 주목받고 있는데요, 이 기술이 가져오는 변화가 꽤 큽니다.

예전엔 대규모 GPU 자원이 있어야 제대로 된 AI 기능을 구현할 수 있었지만, 이제는 중소기업도 sLLM을 활용하면 고성능 AI를 자체 시스템에 쉽게 녹여낼 수 있어요. 덕분에 초기 투자 비용이 확 줄어들죠. 비용 효율성(💸) 측면에서 굉장한 매력포인트입니다. 그리고 엣지 컴퓨팅(🎯) 측면에서도 기대할 만한 변화가 있습니다. 이제는 디바이스 자체에서 AI 추론이 가능해져서, 사용자 데이터를 굳이 서버로 보내지 않아도 됩니다. 이건 특히 개인정보 보호가 중요한 헬스케어나 금융, 교육 분야에서 굉장히 큰 이점이에요.

또 하나, 실시간 반응(⚡)이 가능해졌다는 점도 주목할 만합니다. 응답 속도가 빠르고 지연 시간이 낮아지다 보니, 챗봇이나 고객지원 같은 서비스에서 사용자 만족도가 확실히 올라가요. 뭔가 물어봤을 때 즉시 답이 오면 훨씬 믿음도 가고, 경험도 좋아지잖아요. 더 나아가, 오픈소스로 공개된 sLLM이 많아지면서 누구나 쉽게 생성형 AI 기능을 자기 서비스에 넣을 수 있게 됐습니다. 이게 바로 AI의 민주화(🌍)라고 할 수 있어요. 다양한 개발자와 기업들이 혁신을 일으킬 수 있는 기반이 되는 거죠.

마지막으로, 클라우드 환경(🌐)에서 쉽게 확장할 수 있다는 점도 빼놓을 수 없어요. 스타트업이나 SaaS 기업 입장에선 글로벌 서비스로 빠르게 확장하는 게 중요한데, sLLM 덕분에 그런 흐름이 훨씬 쉬워졌습니다.

📒 참고문헌

- Harvard Business Review. (2025, September 8). The Case for Using Small Language Models.

- CEVA. (2025). The 2025 Edge AI Technology Report.

- Deloitte. (2024. December 11). What’s next for AI? Small language models (SLMs) can be trained by enterprises…

✅ 최신 IT업계 동향과 클라우드 인사이트를 놓치고 싶지 않다면?!

카카오클라우드의 뉴스레터 '카클레터'를 구독하세요! 👉 '카클레터' 구독하러 가기

(*썸네일 & 상단 이미지 출처: Unsplash의 fabio)

댓글